Künstliche Intelligenz in Cochlea-Implantaten

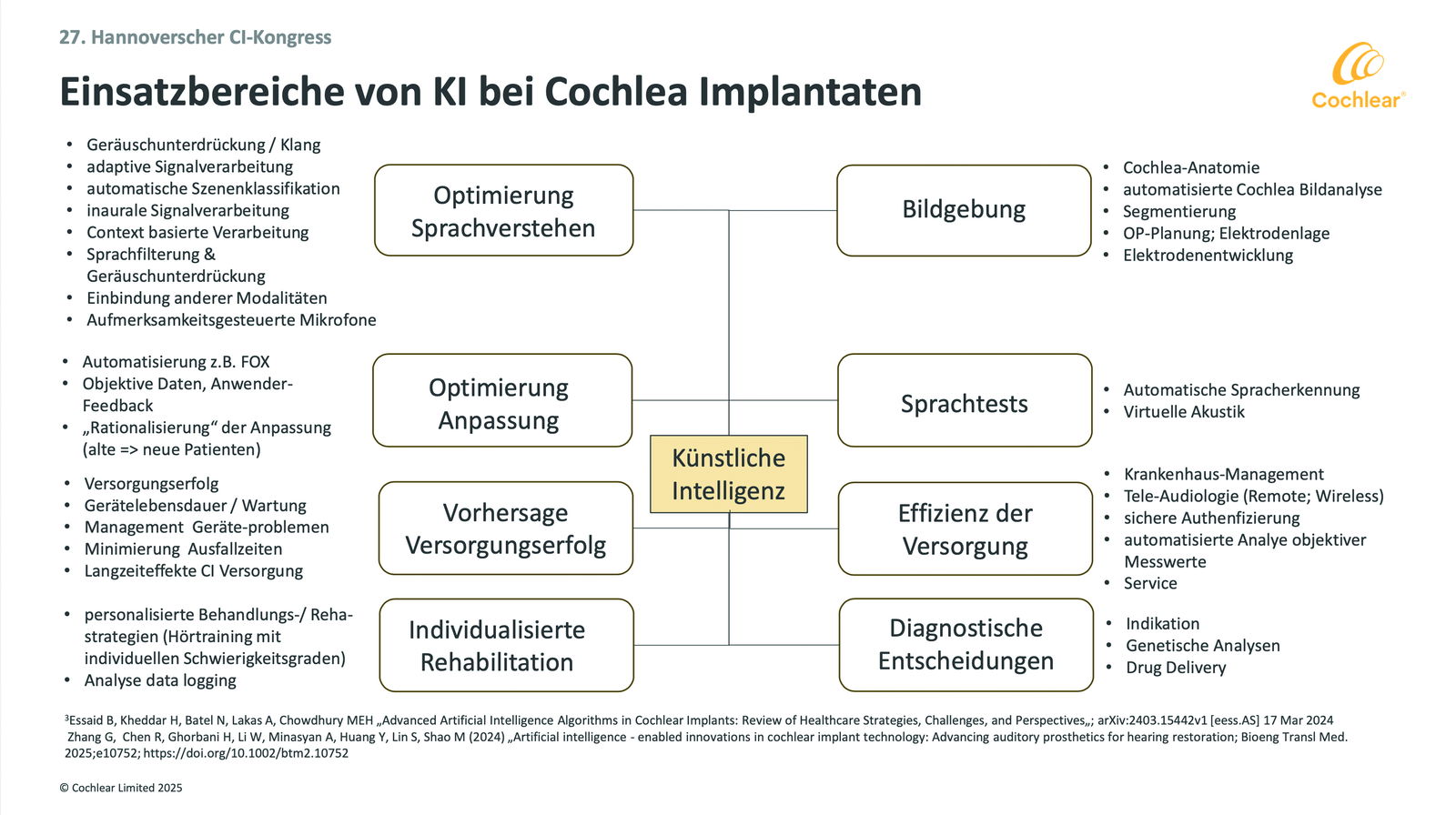

Welche Vorteile bietet Künstliche Intelligenz (KI) heute und zukünftig in Cochlea-Implantat-Systemen (CI)? Antwort gab Dr. Horst Hessel, Research Manager von Cochlear Deutschland, beim 27. Hannoverschen Cochlea-Implantat-Kongress. In einem Vortrag nannte er acht Bereiche, in denen KI die CI-Versorgung bereits prägt bzw. prägen wird.

Von Martin Schaarschmidt/ Foto & Abbildung: Cochlear

1. Optimierung des Sprachverstehens

Voraussetzung für optimales Sprachverstehen ist immer, den interessierenden Schall bestmöglich vom störenden Lärm zu trennen. Verschiedene KI-Funktionen könnten diese Trennung ermöglichen; einige werden dafür bereits erfolgreich genutzt. Der Klang wird optimiert. Geräusche werden unterdrückt, Signale adaptiv verarbeitet und akustische Szenarien automatisch klassifiziert. Anhand des Inputs beider Ohren können die Signale auch binaural verrechnet werden. Man kann Sprache erkennen und herausfiltern. Zukünftig lässt sich Sprache anhand eines Kontextes verarbeiten oder unter Berücksichtigung anderer Sinne. Untersucht wird auch, inwieweit man die Intentionen des Nutzers durch aufmerksamkeitsgesteuerte Mikrofone einbinden kann.

Derzeit »erkennt« das CI noch nicht, mit wem man sprechen möchte. Andere Optionen werden schon länger genutzt und weiter perfektioniert. Exemplarisch lässt sich das an der Entwicklung der Signalvorverarbeitung zeigen. Eine erste Vorverarbeitung eingehender Signale ermöglichte Cochlear ab 1997 mit ADRO (Adaptiv Dynamic Range Optimization) beim Soundprozessor Cochlear Sprint. Nächste Stufen waren Cochlear SmartSound (im Cochlear Freedom von 2005) und Cochlear SmartSound 2 (im Cochlear Nucleus 5, 2009). Hier erfolgte die Vorverarbeitung bereits passend zu verschiedenen Hörsituationen: Alltag, Lärm, Fokus, Musik. Doch mussten diese Situationen von Nutzer oder Audiologen noch aktiv ausgewählt werden.

Das änderte sich 2013 mit Cochlear SmartSound iQ mit SCAN im Cochlear Nucleus 6: SCAN analysierte und klassifizierte erstmals automatisch verschiedene Hörsituationen. Voraussetzung: Cochlear hatte das System zuvor so trainiert, dass es eingehende Signale verschiedenen akustischen Szenarien zuordnen und dann jeweils passend vorverarbeiten konnte.

Hier wurde also erstmals Maschinelles Lernen genutzt. Entscheidende Voraussetzung hierfür war die Nutzbarkeit hochwertiger Daten; und diesbezüglich war dem Hersteller bereits beim Cochlear Freedom ein wichtiger Schritt gelungen: Hier nutzte ein CI-Soundprozessor erstmals zwei Mikrofone. Er bot somit auch die Möglichkeit, die Richtung eingehender Signale zu unterscheiden. Der Ansatz des Maschinellen Lernens, der die SCAN-Funktion ermöglichte, wurde in der Folge mit SCAN mit ForwardFocus mit manueller Aktivierung (Cochlear Nucleus 7, 2017) sowie mit SCAN2 mit ForwardFocus mit automatischer Aktivierung (Cochlear Nucleus 8, 2022) fortgeführt.

Beim Szenen-Klassifikator moderner CI-Systeme wie Cochlear Nucleus 7, Cochlear Kanso 2 und Cochlear Nucleus 8 werden die eingehenden Signale beider Mikrofone in diesem Netzwerk abgeglichen – anhand zahlreicher Merkmale: Der Schallpegel wird bestimmt – und das separat für ruhige oder laute Hörsituationen. Ebenso vergleicht man die Tonalität des Signals, Modulationstiefe und spektrale Rauhigkeit, die Rhythmizität, das spektrale Histogramm und die Variation spektraler Steigungen. Zudem werden Windgeräusche erkannt. Anhand all dieser Merkmale klassifiziert das System die Signale, ordnet sie einem bestimmten akustischen Szenario zu und aktiviert automatisch alle Signalvorverarbeitungen und Mikrofoncharakteristiken.

2. Optimierung der Anpassung

Cochlea-Implantat-Systeme müssen angepasst werden. Entscheidend für den Erfolg einer Anpassung sind u.a. das Know-how und die Erfahrung des jeweiligen Audiologen. Doch mit KI lässt sich der Anpassprozess standardisieren und optimieren. Gearbeitet wird etwa an Lösungen zur Automatisierung. Anhand einer Vielzahl objektiver Messdaten sowie subjektiver Anwender-Feedbacks könnten solche Lösungen zu noch besseren Ergebnissen verhelfen – und das in noch kürzerer Zeit. Die Erfahrungen (bzw. Daten) vieler versorgter Patienten würden automatisch in die Versorgung neuer Patienten einfließen.

Auch hierzu ein Beispiel: Amplitude, Pulsweite, Stimulationsrate, Anzahl der Kanäle, Anzahl der Maxima, Inter-Puls-Gap … – bei der Programmierung der MAP eines CI-Systems lassen sich zahlreiche Parameter einstellen. Doch das Zusammenspiel dieser Parameter ist komplex: Jeder einzelne der genannten Parameter beeinflusst die wahrgenommene Lautstärke. Und die Parameter interagieren auch untereinander. Das heißt, wenn man einen Parameter verändert, ändern sich dadurch auch andere – und sie verändern somit wiederum die Wahrnehmung der Lautstärke …

Folge dieser Komplexität ist bisher eine große Varianz bei Anpassungen. Auch wenn man die Anpassungen von Systemen verschiedener Hersteller vergleicht, ergibt sich ein eher heterogenes Bild (2). Das alles führt zu erheblichen Schwankungen bei der erreichten Performance. Mit KI könnten solche Schwankungen vermieden werden.

Cochlear arbeitet derzeit an der Entwicklung einer eigenen KI-basierten, automatisierten Software, bei der vier verschiedene Quellen miteinander verbunden werden: zum einen große Datenmengen aus den vorhandenen Datenbanken, zweitens die Prognose bzw. das Therapie-Ziel für den jeweiligen Patienten sowie drittens das individuelle Know-how führender Audiologen, die sich – je nach Prognose – für Lösung X, Y oder Z entscheiden würden. Hinzu kommen viertens die objektiven individuellen Messungen.

3. Vorhersagen zum Erfolg der CI-Versorgung

Wie werde ich mit dem Cochlea-Implantat hören? Das fragt sich jeder, der vor der Entscheidung für eine Versorgung steht. Der Austausch mit CI-Trägern bietet hier zwar Orientierung, doch Erfahrungen und Versorgungserfolge sind immer individuell.

KI kann anhand einer Fülle von Daten den Erfolg einer Versorgung ungleich genauer vorhersagen. Ebenso könnte die KI Aussagen zur Lebensdauer der Technik oder zum Einfluss bestimmter Wartungen auf diese Lebensdauer treffen. Die KI könnte auch Probleme der Technik managen, Ausfallzeiten minimieren oder Effekte der CI-Versorgung über lange Zeit berücksichtigen.

4. Individualisierte Rehabilitation

Welches Hörtraining ist für diesen Patienten geeignet? Welcher Schwierigkeitsgrad ist angemessen für ihn? Auch bei der Entwicklung personalisierter Behandlungs- bzw. Reha-Strategien kann KI unterstützen. Nutzen lassen sich dabei etwa Ergebnisse des Data-Loggings: Wie lange trägt der Patient sein CI? Wie könnte er die Technik noch besser nutzen? Was empfiehlt man ihm? Schon bisher liefert Data-Logging eine Fülle individueller Nutzerdaten. Doch deren Interpretation obliegt bislang einem einzelnen Menschen – dem Audiologen, der diese Daten anhand seines Wissens subjektiv deutet. Eine KI kann diese Datenflut viel gründlicher durchdringen und viel konsequenter berücksichtigen.

Wieder ein Beispiel: Die Funktion SCAN ermöglicht auch die automatische Registrierung des Data Logging. Nutzungsdauer und Hörsituationen, Lautstärke, Verwendung von Zubehör, Aktivierung von Programmen und von FowardFocus – zahlreiche Daten werden erfasst und beschreiben das Nutzerverhalten. Auf dieser Basis kann man den CI-Träger individuell passend beraten. Voraussetzung hierfür ist allerdings, dass Audiologe oder CI-Akustiker wissen, welches Nutzerverhalten generell »normal« bzw. optimal ist.

Hier helfen automatisch erfasste Daten aus Untersuchungen zum Nutzerverhalten mit CI. Sie zeigen etwa, dass sich Senioren eher in ruhigen Umgebungen aufhalten, und dass junge CI-Träger mehr Musik hören, dass sich die beiden Gruppen jedoch bei der täglichen Nutzungsdauer kaum unterscheiden (3). Eine andere Untersuchung zeigt, dass CI-Patienten leisere Hörsituationen zwischen 50 und 60 Dezibel bevorzugen, während sie lautstarke Situationen über 65 Dezibel eher vermeiden (4). Die individuellen Daten eines Data Loggings könnte die KI mit solchen objektiven Daten abgleichen und daraus Konsequenzen für die Therapie herleiten. Diese maßgeschneiderten Empfehlungen könnten sowohl dem Patienten als auch Audiologen, Ärzten und Therapeuten Orientierung bieten.

5. Bildgebung

KI kann schon heute alle möglichen Bilder erkennen und erzeugen. Auch bei der CI-Versorgung wird KI diesbezüglich schon genutzt: Wie ist die Cochlea anatomisch gestaltet? Wie können dementsprechend die CI-Elektroden platziert werden? Welcher Zugang zum Innenohr empfiehlt sich für den Operateur – eine Cochleostomie oder eine Rundfensterinsertion? Die KI analysiert die Bilddaten automatisch. Sie kann das MRT-Bild der Cochlea in Segmente zerlegen und eine 3D Darstellung erzeugen. Sie kann berechnen, wie groß der Abstand zwischen Elektrodenkontakt und Modiolus wäre und vieles mehr. Das bringt erhebliche Vorteile für die Planung von Operationen, aber auch für die Entwicklung neuer CI-Elektroden.

6. Sprachtests

Tests zum Sprachverstehen mit dem CI erfolgen heute zumeist noch manuell. Doch KI kann Sprache automatisch erkennen. Auch das Erkennen von nonverbalen Sprachanteilen oder von Emotionen eines Sprechers sind heute bereits möglich. Und die KI kann Akustik virtuell erzeugen. Das alles eröffnet auch für Sprachtests neue Möglichkeiten. Man könnte Tests mit virtueller Akustik auch aus der Ferne (Remote) durchführen. Alle Rückmeldungen des CI-Trägers erfasst die KI automatisch und wertet sie sofort aus. Mitschreiben muss dann niemand mehr.

7. Effizientere Versorgungen

Eine gute Patientenbetreuung braucht ausreichend Zeit und Personal. Angesichts steigender Patientenzahlen stellen sich entscheidende Fragen: Wie kann man Ressourcen effizient einsetzen und Prozesse optimieren? Wie lässt sich die Qualität der Versorgung für immer mehr Menschen sicherstellen und erhöhen? Auch hier kann KI helfen – etwa beim Krankenhaus-Management oder in der Tele-Audiologie. Ebenso hilft sie beim Schutz der Daten, zum Beispiel bei der sicheren Authentifizierung. Objektive Messwerte lassen sich mit ihr automatisch analysieren. Und sie kann den Service verbessern.

8. Diagnostische Entscheidungen

Die medizinische Indikation für CI-Versorgungen basiert auf zahlreichen Kriterien: Wie ist der Hörverlust eines Patienten? Wie ist seine Anatomie? Welche Wünsche hat er? Welche technischen Spezifikationen bieten die verschiedenen CI-Systeme? Bei akustischen Hörsystemen: Wie unterscheiden sie sich zum Beispiel mit Blick auf den Frequenzbereich, der kompensiert werden muss? Was wäre demnach die optimale Lösung für den Patienten?

Immer mehr Möglichkeiten zur Personalisierung verlangen nach immer mehr Entscheidungen. Der Operateur allein kann diese kaum noch überschauen bzw. treffen. Hier kann KI den Arzt in der diagnostischen Entscheidung unterstützen, insbesondere wenn es mehrere Therapieoptionen gibt. Und KI könnte auch bei der Erstellung genetischer Analysen effektiv unterstützen.

KI im Implantat – ein Ausblick

Bislang war ein Upgrade des Soundprozessors der einzige Weg, um neue KI-Anwendungen nutzbar zu machen. Mit der Einführung des ersten smarten Cochlea-Implantats hat sich dies grundlegend geändert: Nucleus Nexa verfügt über einen Chip, der es erlaubt, das Implantat auch mit zukünftigen Neuerungen (Firmware Upgrades) auszustatten. Darüber hinaus bieten Upgrades des Soundprozessors auch weiterhin Zugang zu neuen Technologien.

Quellen:

1 - Essaid B, Kheddar H, Batel N, Lakas A, Chowdhury MEH »Advanced Artificial Intelligence Algorithms in Cochlear Implants: Review of Healthcare Strategies, Challenges, and Perspectives«; arXiv:2403.15442v1 [eess.AS] 17 Mar 2024 Zhang G, Chen R, Ghorbani H, Li W, Minasyan A, Huang Y, Lin S, Shao M (2024) »Artificial intelligence – enabled innovations in cochlear implant technology: Advancing auditory prosthetics for hearing restoration«; Bioeng Transl Med. 2025;e10752; https://doi.org/10.1002/btm2.10752

2 - Browning LM, Nie Y, Rout A, Heiner M (2020): »Audiologists’ preferences in programming cochlear implants: A preliminary report«, Cochlear Implants International, DOI: 10.1080/14670100.2019.1708553

3 - Oberhoffner T, Hoppe U, Hey M, Dietmar Hecker D, Bagus H, Voigt P, Schicktanz S, Braun A, Hocke T »Multizentrische Analyse des Nutzerverhaltens von Cochlea-Implantat-Trägern« Laryngo-Rhino-Otol 2017

4 - Hey M, Hocke T, Ambrosch P (2017) »Sprachaudiometrie und Datalogging bei CI-Patienten – Überlegungen zu geeigneten Sprachpegeln«; HNO https://doi.org/10.1007/s00106-017-0418-9